이제 AWS 사용자라면 업계 벤치마크에서 입증된 강력한 AI 훈련 및 추론 성능에 액세스할 수 있답니다!

이 거대한 클라우드 기업은 엔비디아 H100 텐서 코어 GPU(NVIDIA H100 Tensor Core GPU)로 구동되는 새로운 아마존 EC2 P5 인스턴스(Amazon EC2 P5 instance)를 공식적으로 출시했는데요, 이 서비스를 통해 AWS 사용자는 브라우저에서 클릭 한 번으로 생성형 AI, 고성능 컴퓨팅(HPC)을 포함한 다양한 애플리케이션으로 확장할 수 있습니다.

이 새로운 소식은 AI가 바야흐로 아이폰 모멘텀(iPhone moment)을 맞이한 직후 나왔는데요, 전 세계의 많은 개발자와 연구원들은 거의 매일 대규모 언어 모델(LLM)을 사용하여 AI 기반 새로운 애플리케이션을 개발하고 있습니다. 이러한 새로운 애플리케이션을 시장에 출시하기 위해서는 가속화된 컴퓨팅의 효율성이 필요합니다.

엔비디아 H100 GPU는 4세대 텐서 코어, LLM 가속화를 위한 새로운 트랜스포머 엔진, 초당 900GB의 속도로 GPU가 서로 통신할 수 있는 최신 NV링크 기술 등의 아키텍처 혁신을 통해 슈퍼 컴퓨팅급 성능을 제공합니다.

P5 인스턴스로 확장

아마존 EC2 P5 인스턴스는 점점 더 복잡해지는 LLM 및 컴퓨터 비전 모델을 위한 추론 훈련 및 실행에 이상적인 서비스입니다. 이러한 뉴럴 네트워크(Neural network)는 질문 답변, 코드 생성, 영상 및 이미지 생성, 음성 인식 등 가장 까다롭고 컴퓨팅 집약적인 생성형 AI 애플리케이션을 구동합니다.

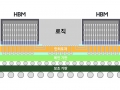

P5 인스턴스는 클라우드의 고성능 컴퓨팅, 네트워킹, 스토리지로 구성된 하이퍼스케일 클러스터인 EC2 울트라클러스터(EC2 UltraClusters)에 배포할 수 있습니다. 각 EC2 울트라클러스터는 강력한 슈퍼컴퓨터로, 고객이 여러 시스템에서 가장 복잡한 AI 트레이닝과 분산된 HPC 워크로드를 실행할 수 있도록 지원합니다.

컴퓨팅 노드 간에 높은 수준의 통신이 필요한 대규모 애플리케이션을 실행할 수 있도록 P5 인스턴스는 아마존 EC2 인스턴스를 위한 3,200Gbps 네트워크 인터페이스인 AWS EFA를 기반으로 하는 페타비트 규모의 논블럭킹 네트워크를 지원합니다.

P5 인스턴스를 통해 머신 러닝 애플리케이션은 엔비디아 콜랙티브 커뮤니케이션 라이브러리(NVIDIA Collective Communications Library)를 사용하여 최대 20,000개의 H100 GPU를 사용할 수 있습니다.

엔비디아 AI 엔터프라이즈(NVIDIA AI Enterprise)는 100개 이상의 프레임워크, 사전 학습된 모델, AI 워크플로우와 AI 인프라 조정을 위한 도구가 포함된 풀스택 소프트웨어 제품군을 통해 사용자가 P5 인스턴스를 최대한 활용할 수 있도록 지원합니다.

AI 애플리케이션의 개발 및 배포를 간소화하도록 설계된 엔비디아 AI 엔터프라이즈는 고성능의 안전한 클라우드 네이티브 AI 소프트웨어 플랫폼 구축 및 유지 관리의 복잡성을 해결합니다. AWS 마켓플레이스에서 사용할 수 있으며, 지속적인 보안 모니터링, 일반적인 취약성과 노출에 대한 정기적이고 시기 적절한 패치, API 안정성, 엔터프라이즈 지원은 물론 엔비디아 AI 전문가의 지원까지 제공합니다.

주요 고객들의 후기

엔비디아와 AWS는 클라우드에 GPU 가속화를 제공하기 위해 지난 10여년 동안 협력해 왔습니다. 이러한 협업의 최신 사례인 새로운 P5 인스턴스는 개발자가 차세대 AI를 개발할 수 있는 최첨단 성능을 제공하기 위한 중요한 진전을 의미합니다.

다음은 현재 사용하고 있는 고객 사례들입니다:

Anthropic은 신뢰할 수 있고 해석 가능하며 조정 가능한 AI 시스템을 구축하여 상업적으로나 공익을 위해 가치를 창출할 수 있는 많은 기회를 갖게 될 것입니다.

“오늘 날의 대규모 일반 AI 시스템은 상당한 이점을 제공할 수 있지만 예측할 수 없고 신뢰할 수 없으며 불투명할 수 있으므로 이러한 문제를 해결하고 사람들이 유용하다고 생각하는 시스템을 배포하는 것이 저희의 목표입니다.”라고 Anthropic의 공동 설립자 Tom Brown이 밝혔습니다. “P5 인스턴스는 P4d 인스턴스보다 상당한 가격 대비 성능 이점을 제공할 것으로 기대하며, 차세대 LLM 및 관련 제품을 구축하는 데 필요한 대규모로 사용할 수 있을 것입니다.”

언어 AI 분야의 선도적인 선구자인 Cohere는 모든 개발자와 기업이 데이터를 안전하게 보호하면서 세계 최고의 자연어 처리(NLP) 기술로 제품을 구축할 수 있도록 지원합니다.

“Cohere는 모든 기업이 언어 AI의 힘을 활용하여 자연스럽고 직관적인 방식으로 정보를 탐색, 생성, 검색, 그리고 조치하고, 각 고객에게 가장 적합한 데이터 환경에서 여러 클라우드 플랫폼에 배포할 수 있도록 지원하는 데 앞장서고 있습니다.”라고 Cohere의 CEO인 Aidan Gomez는 말합니다. “엔비디아 H100 기반 아마존 EC2 P5 인스턴스는 컴퓨팅 성능과 Cohere의 최첨단 LLM 및 생성형 AI 기능을 결합하여 기업이 더 빠르게 생성, 성장 및 확장할 수 있는 능력을 발휘할 것입니다.”라고 소감을 마쳤습니다.

Hugging Face는 우수한 머신러닝을 대중화시킨다는 사명을 가지고 있습니다.

“저희는 머신 러닝을 위한 가장 빠르게 성장하는 오픈 소스 커뮤니티로서, 우리는 NLP, 컴퓨터 비전, 생물학, 강화 학습 등을 위한 플랫폼에서 150,000개 이상의 사전 학습된 모델과 25,000개 이상의 데이터 세트를 제공하고 있습니다.”라고 Hugging Face의 최고 기술 책임자이자 공동 창립자인 Julien Chaumond는 밝혔습니다. “저희는 모든 사람을 위한 새로운 파운데이션 AI 모델의 제공을 가속화하기 위해 EFA가 포함된 UltraClusters에서 Amazon SageMaker를 통해 아마존 EC2 P5 인스턴스를 대규모로 사용할 수 있다는 사실에 매우 기대하고 있습니다.”

오늘날 전 세계 4억5천만 명 이상의 사람들이 Pinterest를 시각적 영감 플랫폼으로 사용하여 자신의 취향에 맞는 제품을 쇼핑하고, 아이디어를 찾고, 영감을 주는 크리에이터와 만나고 있습니다.

“저희는 플랫폼에 업로드되는 수십억 장의 사진에 라벨을 붙이고 분류하는 작업과 사용자가 영감에서 행동으로 옮길 수 있는 시각적 검색과 같은 사용 사례를 위해 플랫폼 전반에 걸쳐 딥러닝을 광범위하게 사용하고 있습니다.”라고 Pinterest의 수석 아키텍트인 David Chaiken이 밝혔습니다. “엔비디아 H100 GPU, AWS EFA, 울트라클러스터가 탑재된 아마존 EC2 P5 인스턴스를 사용하여 제품 개발을 가속화하고 고객에게 새로운 공감형 AI 기반 경험을 제공할 수 있기를 기대하고 있습니다.”라고 소감을 마쳤습니다.

엔비디아 H100 기반의 새로운 AWS P5 인스턴스에 대해 자세히 알아보세요.

출처 - 엔비디아

![뚜따에 진심인 형+과학자코스프레+현미경을구입했어 [정종철] 뚜따에 진심인 형+과학자코스프레+현미경을구입했어

CPU 뚜따 교육자료ㅋㅋ](https://raptor-hw.net/xe/files/thumbnails/739/203/241x165.crop.jpg)